A OpenAI anunciou recentemente seu modelo GPT-4o, um novo modelo carro-chefe do mecanismo que alimenta o ChatGPT, seu famoso chatbot com tecnologia de IA lançado pela primeira vez em 2022. Este modelo mais recente leva a interação humano-computador a um nível totalmente novo, fazendo-a parecer mais rápida e muito mais natural.

No GPT-4o, o ‘o’ significa ‘omni’, pois combina texto, imagem e áudio em um único modelo. Embora não haja nenhuma melhoria na inteligência e no raciocínio em relação ao modelo GPT-4 Turbo, há muitas novas atualizações. Ele foi projetado para fornecer respostas mais rápidas e com aparência mais humana e pode até simular emoções. Também é consideravelmente mais rápido na compreensão de entradas visuais e de áudio. Neste mergulho profundo, daremos uma olhada nos recursos que o GPT-4o oferece e como ele revolucionará a maneira como interagimos com os assistentes de IA. Então junte-se a nós e vamos começar!

GPT-4o é significativamente mais rápido

O modelo GPT-4o permite que o ChatGPT aceite entradas em vários formatos, incluindo áudio, texto, imagens ou suas combinações. Também pode fornecer respostas em diferentes formatos. O que é mais impressionante nisso, entretanto, é a velocidade com que fornece respostas.

Com o novo modelo, o ChatGPT leva cerca de 320 milissegundos ou até menos para responder às entradas de áudio, o que é próximo ao tempo que uma pessoa leva para responder em uma conversa. Além disso, o desempenho do GPT-4o é semelhante ao GPT-4 Turbo no que diz respeito ao uso do inglês ou à escrita de código.

Ele também se sai muito melhor ao responder a entradas baseadas em texto em idiomas diferentes do inglês e é consideravelmente mais barato na API, pois é muito mais eficiente que seu antecessor.

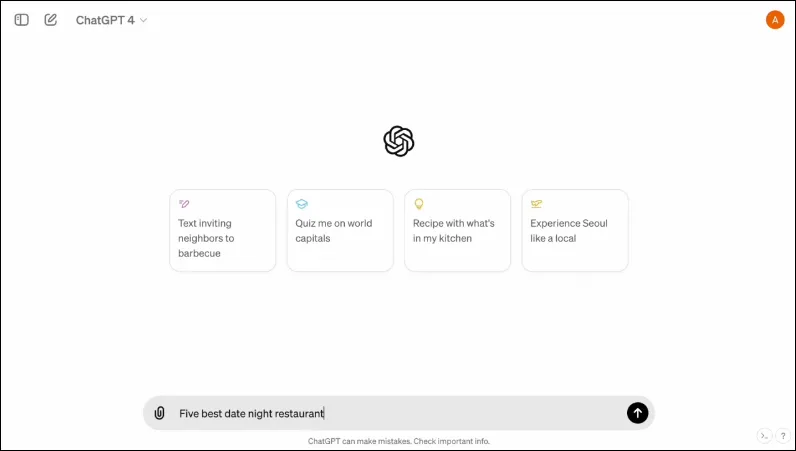

Também possui uma nova interface, projetada para tornar a interação mais fácil e organizada.

É multimodal

O modo de voz existente do ChatGPT consiste em três modelos. O primeiro recebe entrada baseada em texto e fornece saída no mesmo formato, enquanto o segundo converte a entrada de áudio em texto, que é recebido pelo ChatGPT para fornecer saída baseada em texto. O último modelo converte texto em áudio.

Porém, esse design resulta em perda de informação, uma vez que o modelo não pode interagir diretamente com a entrada de áudio ou apresentar saída que contenha elementos emocionais. Com o GPT-4o, a OpenAI construiu um modelo multimodal único que pode compreender diferentes tipos de entradas e processar diretamente a saída necessária.

Atualmente suporta 50 idiomas e também estará disponível como API.

Pode simular emoções humanas

Quando o ChatGPT foi anunciado pela primeira vez, uma das maiores desvantagens do chatbot de IA para muitas pessoas era que ele não conseguia fornecer respostas emocionais. Com o GPT-4o, o ChatGPT pode simular emoções humanas e fornecer respostas adequadas que integrem tais emoções.

Nas demos compartilhadas pela OpenAI, o chatbot pode ser visto rindo, cantando e até mostrando sarcasmo quando solicitado. Isso está muito acima do que qualquer outro chatbot de IA pode fazer atualmente e tornará as interações do usuário muito mais agradáveis. De acordo com a OpenAI, o novo modelo permitirá que o ChatGPT detecte também o humor do usuário e forneça respostas adequadas com base nessas informações.

Combinada com a capacidade de utilizar informações visuais, a capacidade de fornecer respostas emocionais é uma das características mais impressionantes que o novo modelo oferece.

O novo modelo pode armazenar uma quantidade maior de informações

Graças ao GPT-4o, o ChatGPT agora pode compreender melhor imagens, como gráficos e fotos e também armazenar mais informações sobre o usuário. Isso também se traduz em respostas que podem conter trechos de texto maiores, o que pode ser útil em vários casos de uso.

Por exemplo, você pode pedir ao chatbot para traduzir trechos maiores de texto agora e ele pode ajudá-lo com a tradução ao vivo. Como ele pode usar entradas visuais e de áudio junto com entradas baseadas em texto, você pode usá-lo para coletar informações de capturas de tela, fotos e outras imagens.

Como pode armazenar uma quantidade maior de informações sem que os usuários precisem reiterá-las, o GPT-4o permite que os usuários participem de conversas com o chatbot de IA. Com mais informações, os usuários podem esperar que as conversas sejam mais sofisticadas.

Salvaguardas no Novo Modelo

Tal como os modelos GPT existentes, o GPT-4o foi concebido tendo em mente certas salvaguardas para garantir a segurança. Os dados de treinamento foram filtrados e o comportamento do modelo foi refinado após o treinamento. A OpenAI também avaliou o modelo de IA em vários parâmetros, como segurança cibernética e persuasão, para evitar incidentes indesejados.

Além disso, os desenvolvedores contaram com a ajuda de mais de 70 especialistas em diversas áreas, como desinformação e psicologia social, para identificar e mitigar riscos que possam ocorrer ou aumentar com o novo modelo. Eles também continuarão a monitorar o uso do chatbot quanto a riscos futuros e a tomar as ações necessárias quando necessário.

Para começar, a OpenAI disponibilizará apenas uma seleção limitada de predefinições de modelos de voz. Também levará em consideração o feedback fornecido pelo usuário para melhorar o modelo e garantir total segurança.

Disponibilidade GPT-4o

Até agora, havia duas versões do ChatGPT disponíveis – uma versão gratuita rodando em GPT 3.5 e uma versão paga que rodava em GPT 4.0 e custava US$ 20 por mês. Este último pode acessar um modelo de linguagem maior, permitindo lidar com maiores quantidades de dados.

O GPT-4o estará disponível para usuários gratuitos e pagos e deverá ser lançado nos dispositivos nas próximas semanas. Ele estará disponível em dispositivos móveis por meio do aplicativo existente, que será atualizado, e um novo aplicativo macOS para desktop também estará disponível além da versão web para usuários de desktop (a versão para Windows chegará ainda este ano).

Para distinguir entre usuários gratuitos e pagos, a OpenAI oferecerá aos usuários pagos cinco vezes mais capacidade do que será oferecida aos usuários gratuitos. Depois de esgotar seu limite, você voltará para o ChatGPT 3.5.

O anúncio da OpenAI sobre o GPT-40 ocorre apenas um dia antes da I/O Developer Conference anual do Google, onde se espera que o Google faça seus próprios anúncios relacionados à IA. A OpenAI também prometeu que mais anúncios estão a caminho, então não há dúvida de que a competição entre os dois rivais está apenas começando a esquentar.

Embora não saibamos quando a OpenAI revelará mais mudanças em seu modelo de IA, sabemos que o GPT-4o está direcionado para dispositivos que executam ChatGPT globalmente. Portanto, cruze os dedos e aguarde a atualização aparecer no seu dispositivo. Até a próxima vez!

Deixe um comentário