Em sua conferência anual I/O na Califórnia, o Google fez vários anúncios relacionados à IA, incluindo novos modelos e atualizações para os existentes. Um dos anúncios mais interessantes foi o Projeto Astra – um assistente multimodal que funciona em tempo real e combina as capacidades do Google Lens e do Gemini para fornecer informações do seu entorno.

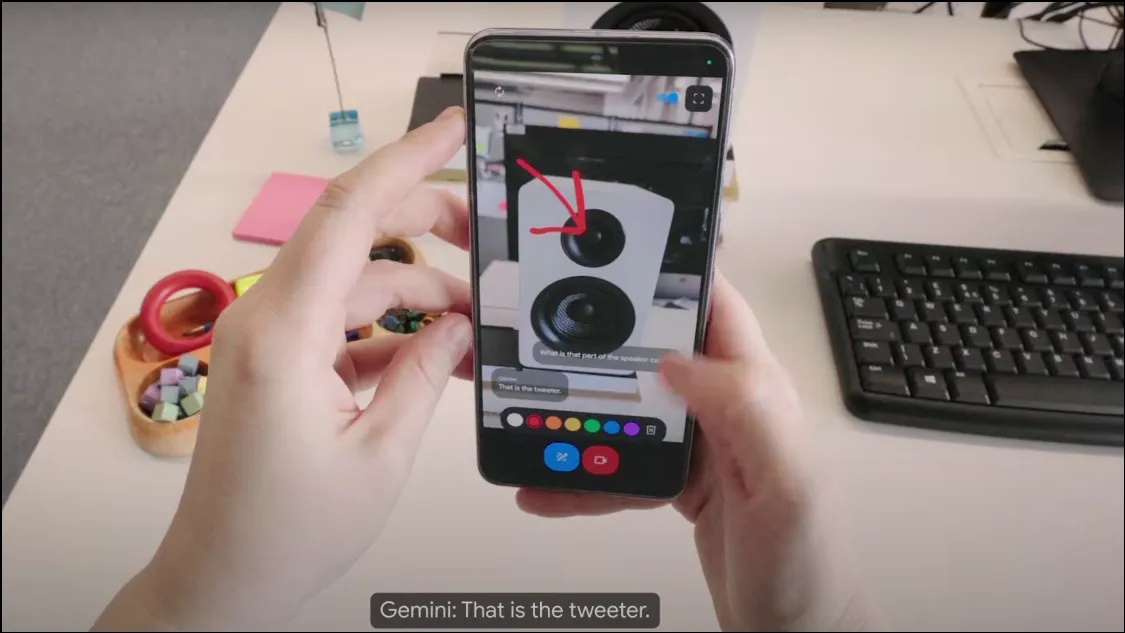

Como funciona o Projeto Astra? Na conferência, o Google exibiu uma versão inicial do Projeto Astra, que funciona como um chatbot baseado em câmera e pode coletar informações ao seu redor usando a câmera do seu dispositivo. Sendo um assistente de IA multimodal, ele pode usar áudio, vídeo e imagens como entradas e fornecer a saída necessária com base nelas. Ele roda no modelo Gemini 1.5 Pro, o que o torna incrivelmente poderoso.

O chatbot analisa objetos e arredores em tempo real e pode responder a perguntas muito rapidamente, tornando-o bastante semelhante a um assistente humano, ou ao querido JARVIS de Tony Stark. O Projeto Astra também funciona com wearables como óculos inteligentes, o que significa que há muito potencial para o chatbot de IA ser integrado em diferentes dispositivos.

O Projeto Astra pode compreender melhor o contexto em que está sendo usado, processar informações com mais rapidez e retê-las para uma recuperação mais rápida. Suas capacidades de fala também foram muito melhoradas em comparação com as dos modelos Gemini anteriores, por isso soa mais natural e humano.

O que o Projeto Astra pode fazer? Na breve demonstração que o Google exibiu, parece que o Projeto Astra pode ajudar a realizar muitas coisas. Ele pode observar e compreender objetos e locais através da lente da câmera e do microfone e fornecer informações sobre eles. Por exemplo, você pode simplesmente apontar seu telefone para um trecho de código e discuti-lo com o chatbot, ou pedir que ele identifique um objeto e seu uso.

Da mesma forma, graças aos recursos de reconhecimento de localização, o Projeto Astra pode fornecer informações sobre a sua localidade apenas observando o que está ao seu redor. Ele também pode reter as informações que lhe são mostradas, o que pode ser bastante útil se você quiser localizar itens perdidos, conforme demonstrado na demonstração quando ajudou o usuário a encontrar seus óculos.

Você também pode pedir ideias criativas ao assistente de IA, assim como faz com o Gemini no seu telefone. Por exemplo, você pode pedir que ele crie a letra de uma música, o nome de uma banda musical ou qualquer outra coisa. Basicamente, o Projeto Astra pretende ser um assistente universal de IA que pode fornecer informações em tempo real de uma forma bastante coloquial.

Quando o Projeto Astra estará disponível? Até o momento, o Google não fez anúncios sobre a disponibilidade do Projeto Astra. A versão mostrada na demonstração é um protótipo inicial, mas o Google sugeriu que esses recursos poderiam ser integrados ao aplicativo Gemini existente posteriormente.

Com o Projeto Astra, o Google se esforça para liderar a evolução dos assistentes de IA para que se tornem ainda mais úteis e fáceis de usar. No entanto, o Google não é o único a perseguir esse objetivo. A OpenAI também anunciou recentemente o GPT-4o, tornando seu ChatGPT multimodal, aprimorando suas capacidades e eficiência. O novo modo de voz do ChatGPT (a ser lançado em breve) também pode usar a entrada de vídeo da câmera do dispositivo enquanto interage com os usuários.

No momento, a diferença entre os dois é que o GPT-4o estará disponível em breve em todos os dispositivos que executam o ChatGPT, enquanto o Project Astra deverá estar disponível como Gemini Live em algum momento no futuro, embora não haja data de lançamento no momento. Com o ChatGPT com tecnologia GPT-4o disponível anteriormente, resta saber se o Projeto Astra do Google será bom o suficiente para rivalizar com o chatbot mais popular da OpenAI.

Deixe um comentário