Se você quiser executar Large Language Models ou LLMs no seu computador, uma das maneiras mais fáceis de fazer isso é por meio do Ollama. Ollama é uma plataforma poderosa de código aberto que oferece uma experiência de IA personalizável e facilmente acessível. Ela facilita o download, a instalação e a interação com vários LLMs, sem precisar depender de plataformas baseadas em nuvem ou exigir qualquer conhecimento técnico.

Além das vantagens acima, o Ollama é bem leve e é atualizado regularmente, o que o torna bastante adequado para construir e gerenciar LLMs em máquinas locais. Assim, você não precisa de servidores externos ou configurações complicadas. O Ollama também suporta múltiplos sistemas operacionais, incluindo Windows, Linux e macOS, assim como vários ambientes Docker.

Baixando e instalando o Ollama

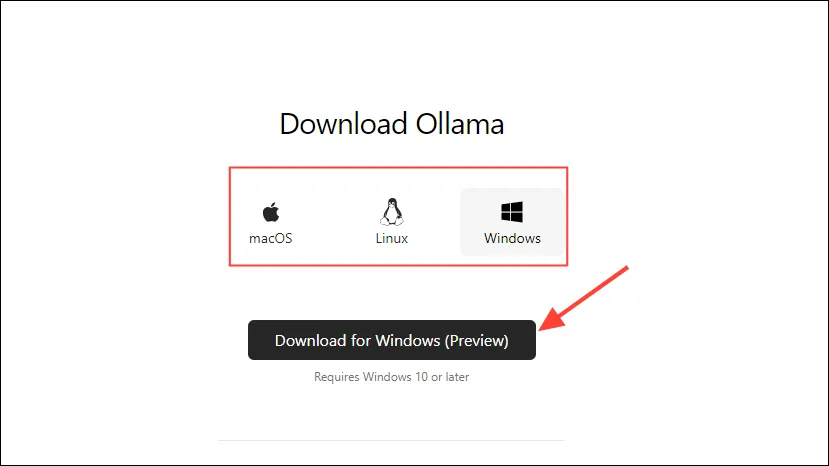

- Primeiro, visite a página de download do Ollama e selecione seu sistema operacional antes de clicar no botão “Download”.

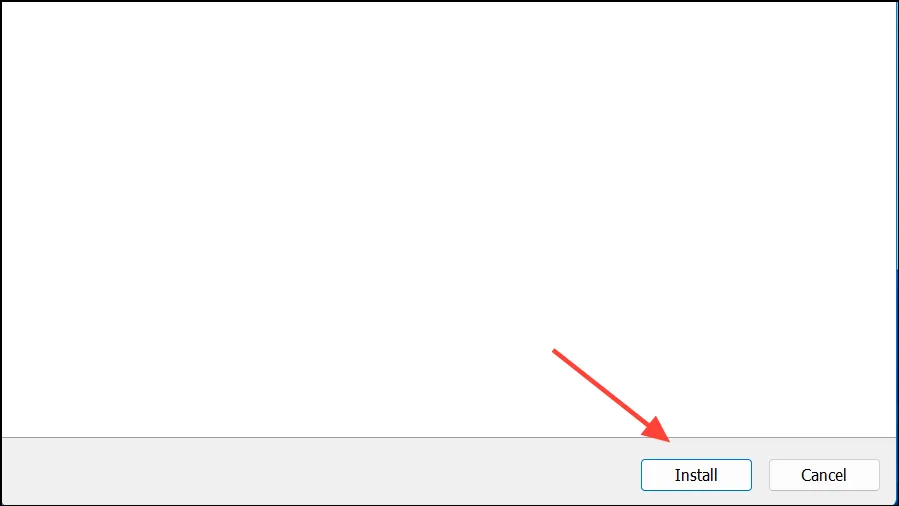

- Assim que o download for concluído, abra-o e instale-o em sua máquina. O instalador fechará automaticamente após a conclusão da instalação.

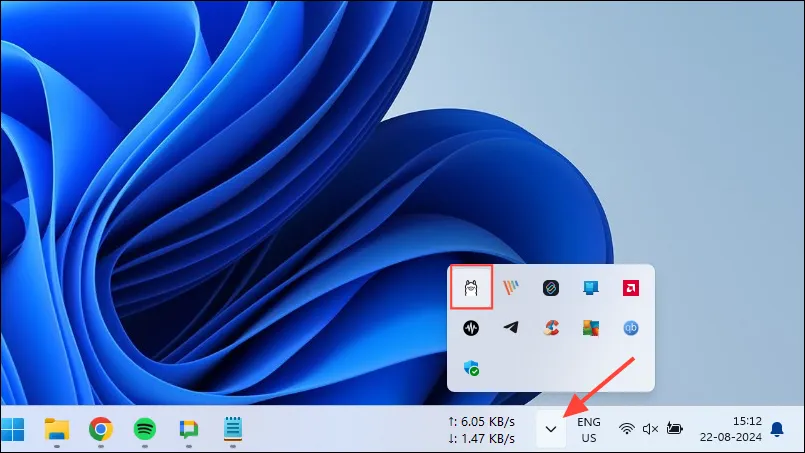

- No Windows, você pode verificar se o Ollama está em execução ou não clicando no botão de estouro da barra de tarefas para visualizar ícones ocultos.

Personalizando e usando Ollama

Depois que o Ollama estiver instalado no seu computador, a primeira coisa que você deve fazer é alterar onde ele armazena seus dados. Por padrão, o local de armazenamento é, C:\Users\%username%\.ollama\modelsmas como os modelos de IA podem ser bem grandes, sua unidade C pode ficar cheia rapidamente. Para fazer isso,

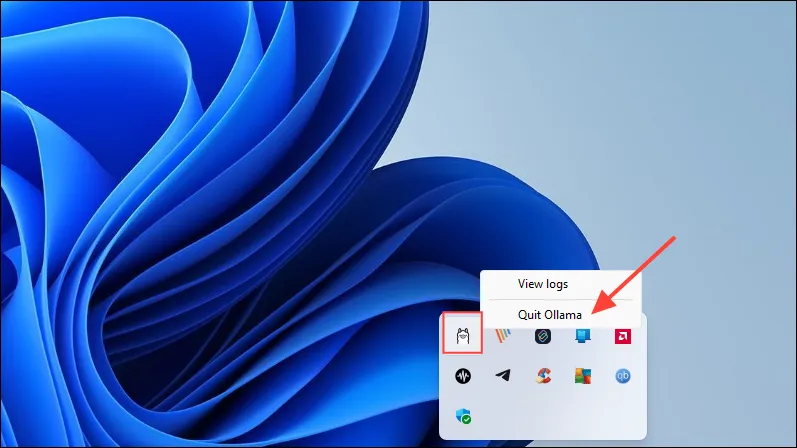

- Primeiro, clique no ícone do Ollama na barra de tarefas e clique em “Sair do Ollama”.

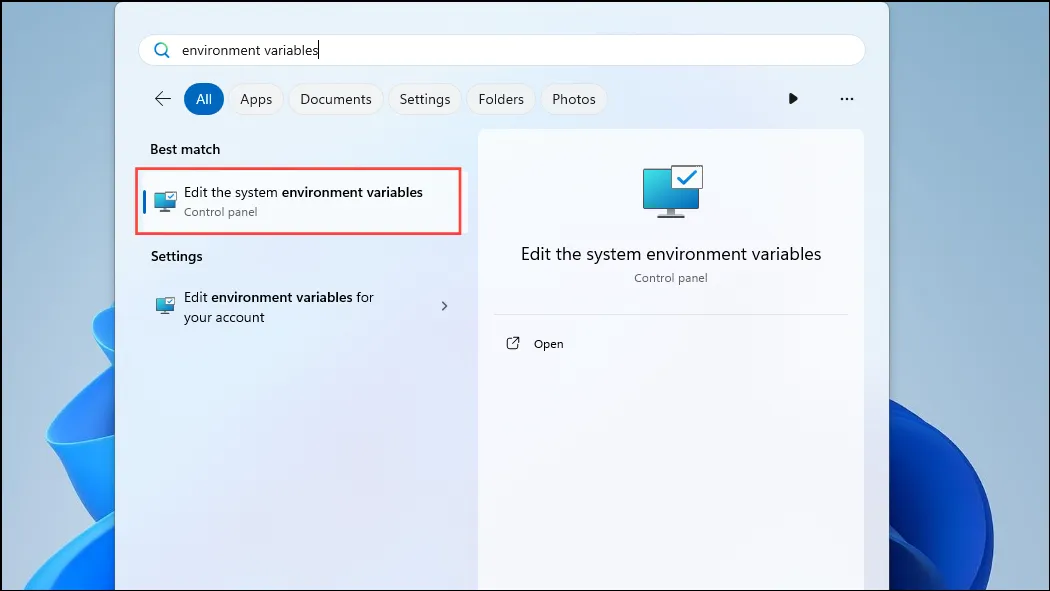

- Depois que o Ollama sair, abra o menu Iniciar, digite

environment variablese clique em ‘Editar as variáveis de ambiente do sistema’.

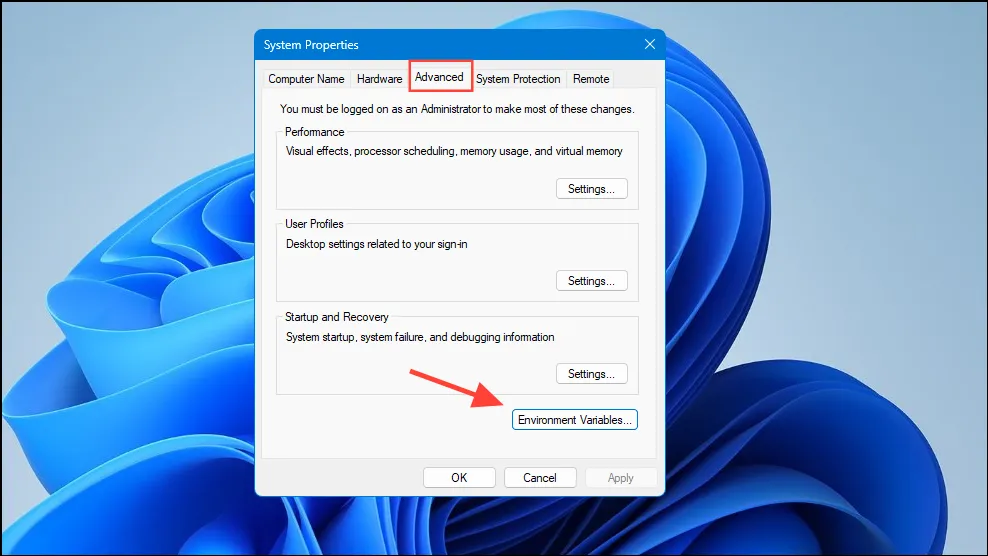

- Quando a caixa de diálogo Variáveis do Sistema abrir, clique no botão “Variáveis de Ambiente” na aba “Avançado”.

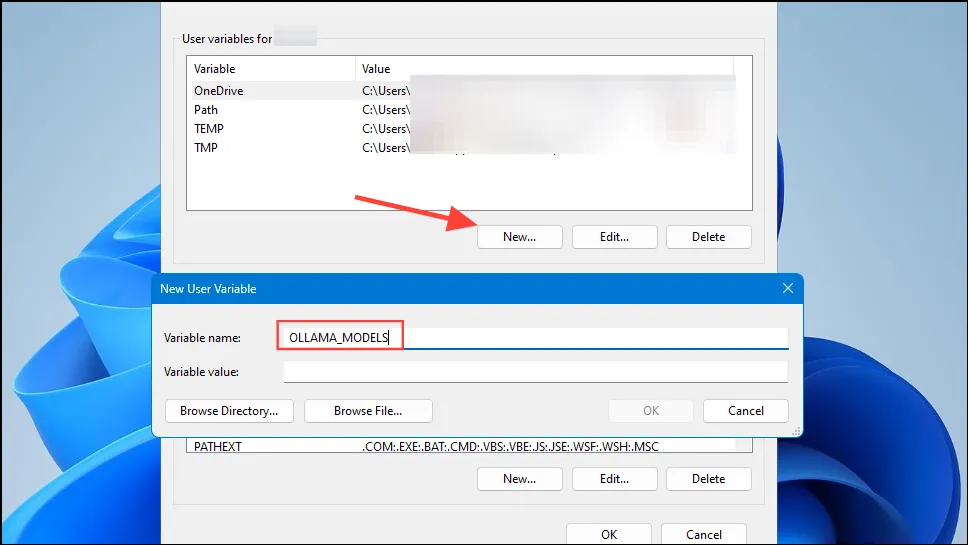

- Clique no botão ‘Novo’ para sua conta de usuário e crie uma variável nomeada

OLLAMA_MODELSno campo ‘Nome da variável’.

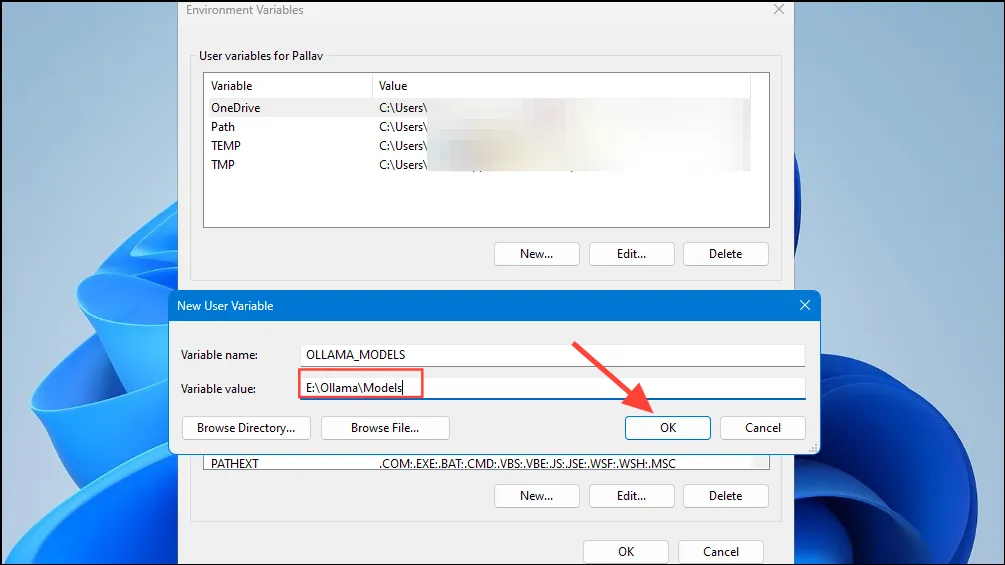

- Em seguida, digite o local do diretório onde você quer que o Ollama armazene seus modelos no campo ‘Valor da variável’. Em seguida, clique no botão ‘OK’ antes de iniciar o Ollama a partir do menu Iniciar.

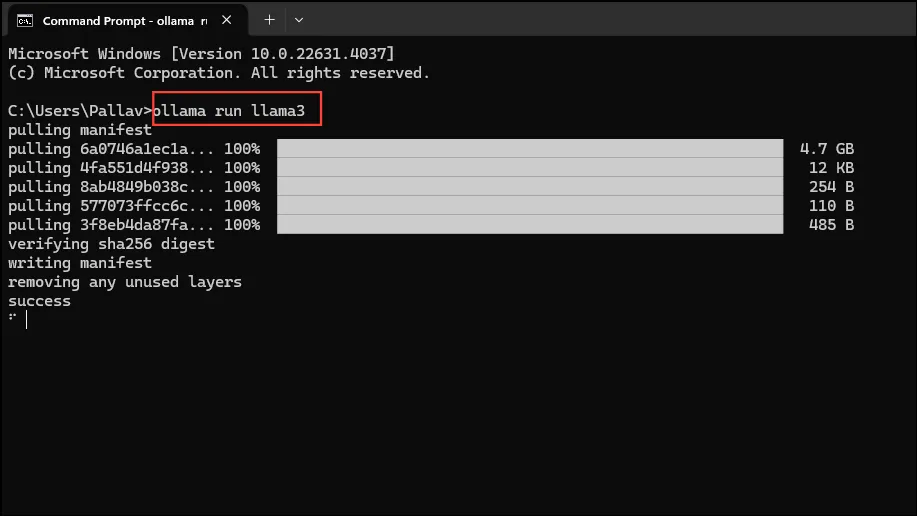

- Agora você está pronto para começar a usar o Ollama, e pode fazer isso com o Llama 3 8B da Meta, o mais recente modelo de IA de código aberto da empresa. Para executar o modelo, inicie um prompt de comando, Powershell ou janela do Terminal do Windows no menu Iniciar.

- Assim que a janela do prompt de comando abrir, digite

ollama run llama3e pressione Enter. O modelo tem quase 5 GB, então baixá-lo levará tempo.

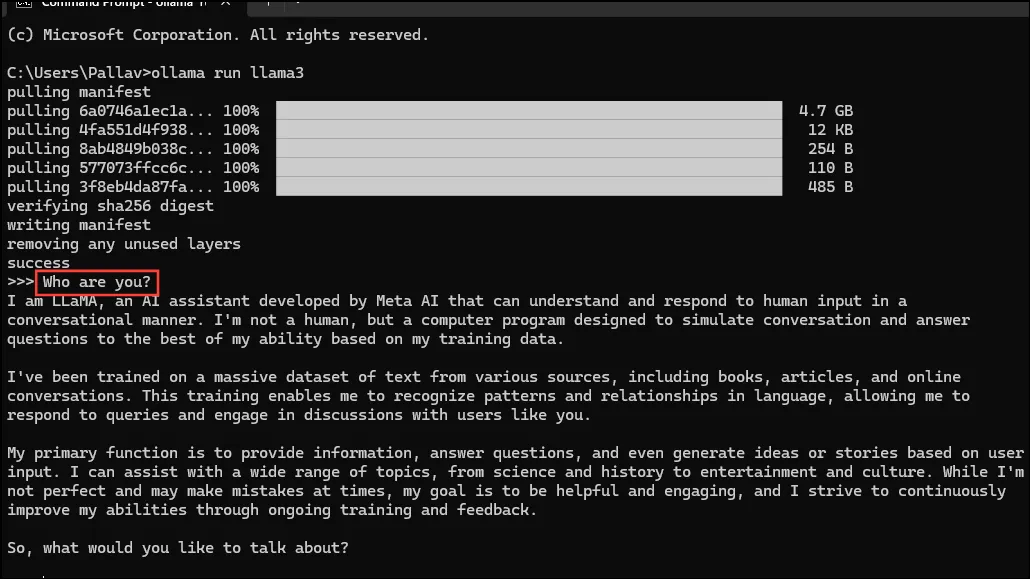

- Assim que o download for concluído, você pode começar a usar o Llama 3 8B e conversar com ele diretamente na janela da linha de comando. Por exemplo, você pode perguntar ao modelo

Who are you?e pressionar Enter para obter uma resposta.

- Agora, você pode continuar a conversa e fazer perguntas aos modelos de IA sobre vários tópicos. Apenas tenha em mente que o Llama 3 pode cometer erros e alucinações, então você deve ter cuidado ao usá-lo.

- Você também pode experimentar outros modelos, visitando a página da biblioteca de modelos Ollama. Além disso, há vários comandos que você pode executar para experimentar diferentes funcionalidades que o Ollama oferece.

- Você também pode executar várias operações durante a execução de um modelo, como definir variáveis de sessão, mostrar informações do modelo, salvar uma sessão e muito mais.

- O Ollama também permite que você aproveite modelos de IA multimodais para reconhecer imagens. Por exemplo, o modelo LLava pode reconhecer imagens geradas pelo DALLE-3. Ele pode descrever imagens em detalhes.

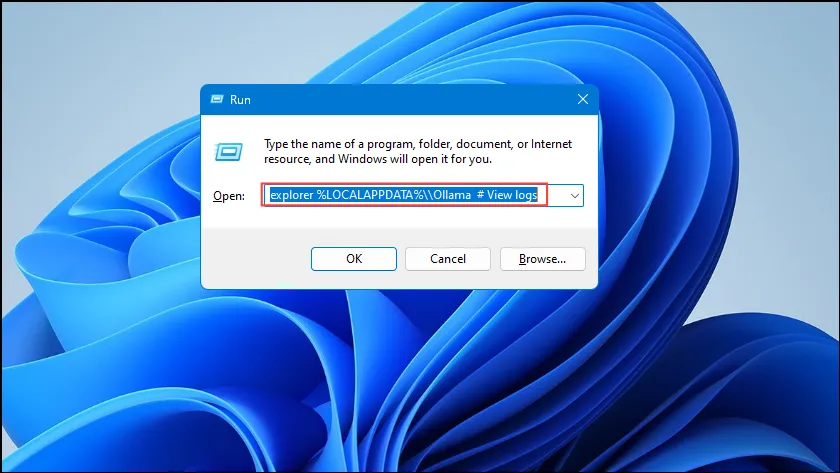

- Se você estiver encontrando erros ao executar o Ollama, você pode verificar os logs para descobrir qual é o problema. Use o

Win + Ratalho para abrir a caixa de diálogo Executar e então digiteexplorer %LOCALAPPDATA%\\Ollama # View logsdentro dela antes de pressionar Enter.

- Você também pode usar outros comandos como

explorer %LOCALAPPDATA%\\Programs\\Ollamaeexplorer %HOMEPATH%\\.ollamapara verificar os binários, o modelo e o local de armazenamento da configuração.

Coisas a saber

- O Ollama detecta automaticamente sua GPU para executar modelos de IA, mas em máquinas com múltiplas GPUs, ele pode selecionar a errada. Para evitar isso, abra o Painel de Controle da Nvidia e defina o Display para ‘Somente GPU Nvidia’.

- O Modo de Exibição pode não estar disponível em todas as máquinas e também não está disponível quando você conecta seu computador a monitores externos.

- No Windows, você pode verificar se o Ollama está usando a GPU correta usando o Gerenciador de Tarefas, que mostrará o uso da GPU e informará qual está sendo usada.

- Embora a instalação do Ollama no macOS e no Linux seja um pouco diferente do Windows, o processo de execução de LLMs por meio dele é bastante semelhante.

Deixe um comentário