Embora muitos navegadores estejam integrando recursos de IA em seus navegadores, o Opera acaba de se tornar o primeiro navegador a integrar modelos locais de IA. A Opera está adicionando suporte experimental para mais de 150 variantes do Local Large Language Model (LLM) de cerca de 50 famílias diferentes de modelos ao seu navegador Opera One.

Como os modelos de linguagem serão locais, os usuários não terão que se preocupar com o envio de seus dados ao servidor do LLM. É uma forma privada e segura de usar IA.

Para usar os modelos LLM locais, você precisará de 2 a 10 GB de espaço em seu computador, dependendo da variante que usará. Alguns dos LLMs suportados incluem Llama da Meta, Phi-2 da Microsoft, Gemma do Google, Vicuna, Mixtral da Mistral AI, etc. Você pode usar esses modelos de linguagem em vez do Aria AI do Opera e voltar para o Aria AI sempre que você querer.

Atualmente, o recurso está disponível apenas no fluxo de desenvolvedores do Opera One. Veja como você pode ativar e usar os modelos locais de IA no Opera One Developer.

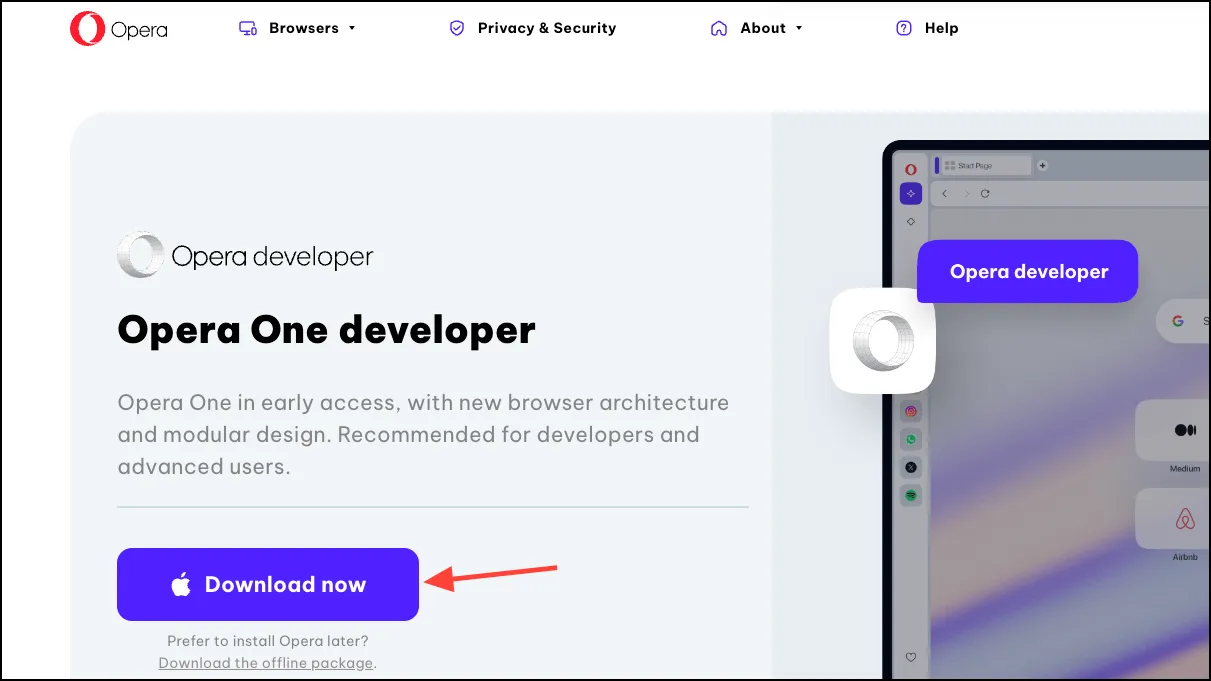

Baixe o desenvolvedor do Opera One

Se você já possui o Opera One Developer, simplesmente pule esta seção e siga em frente para usar os modelos LLM locais.

- Acesse este link para baixar o Opera One Developer. Role para baixo e clique em ‘Baixar agora’ no bloco Opera One Developer.

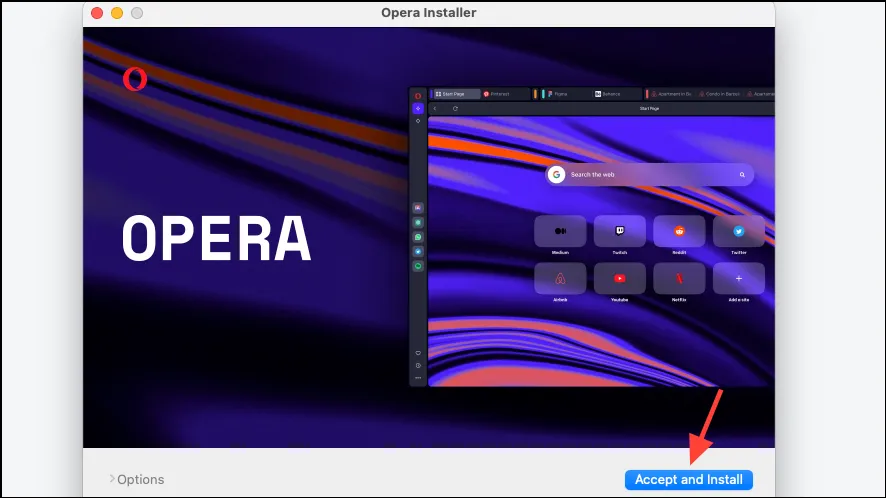

- Abra o arquivo após o download e execute o instalador.

- Clique em ‘Aceitar e instalar’ e siga as instruções na tela para instalar o navegador.

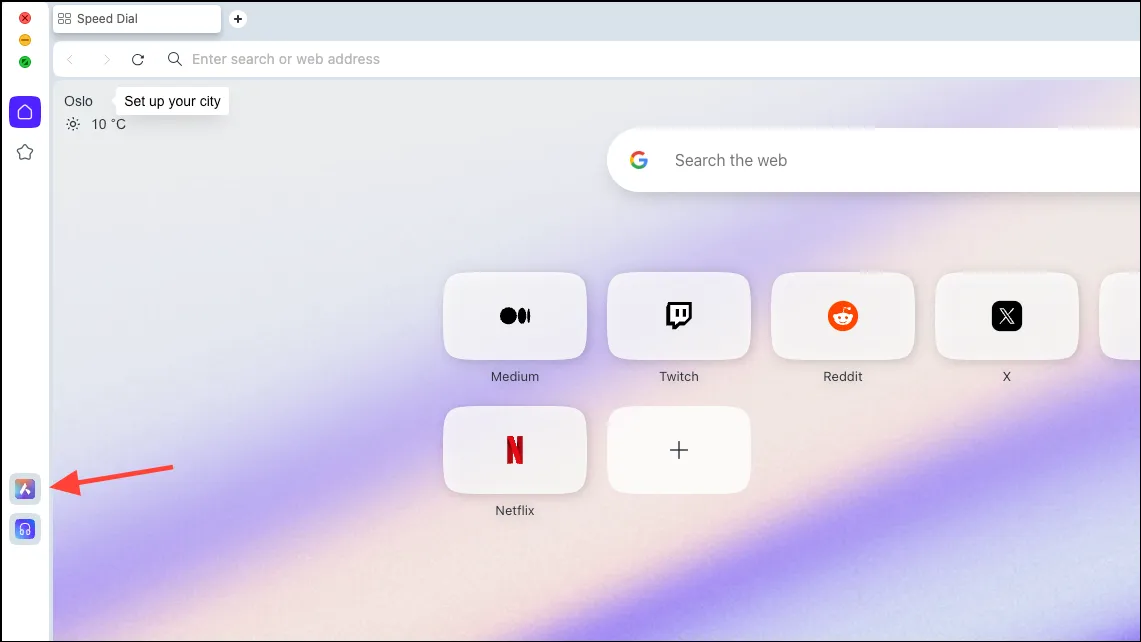

Configurar modelo de IA local

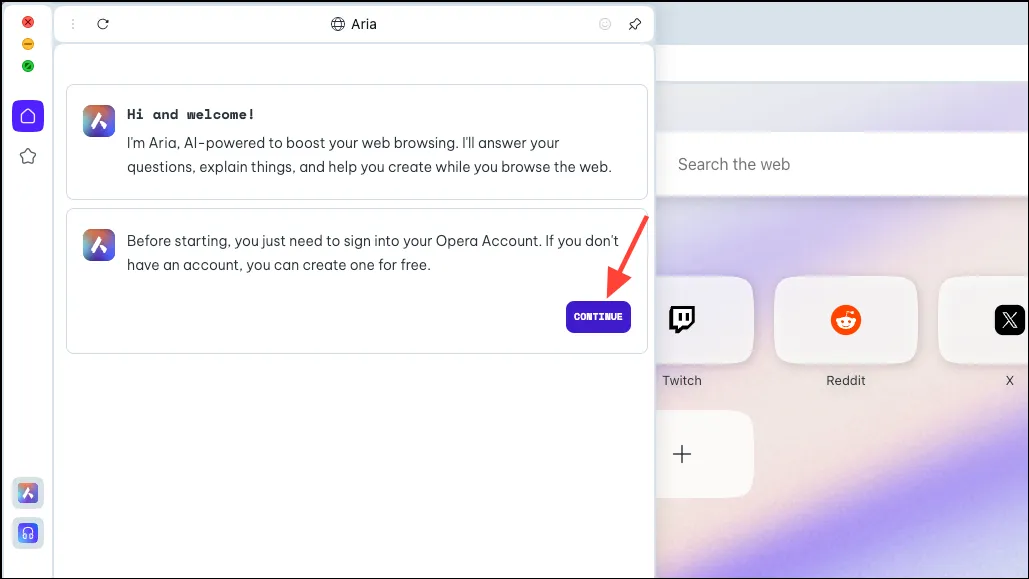

- Após o download do navegador, clique no ícone ‘Aria AI’ na barra lateral esquerda.

- Clique em ‘Continuar’ para prosseguir.

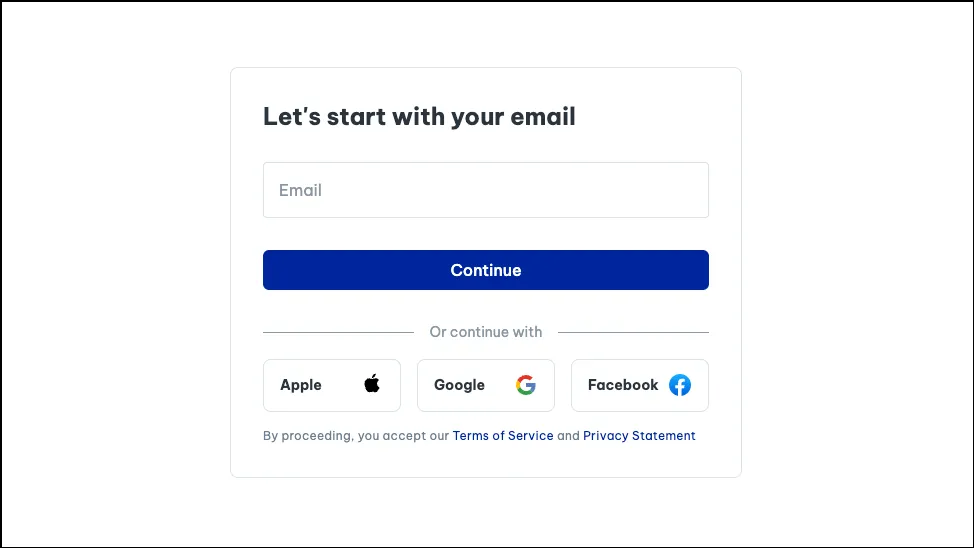

- Se estiver usando o Aria pela primeira vez, você precisará se inscrever em uma conta gratuita do Opera para usá-lo. Você pode usar seu e-mail ou conta Apple, Facebook ou Google para criar uma conta Opera.

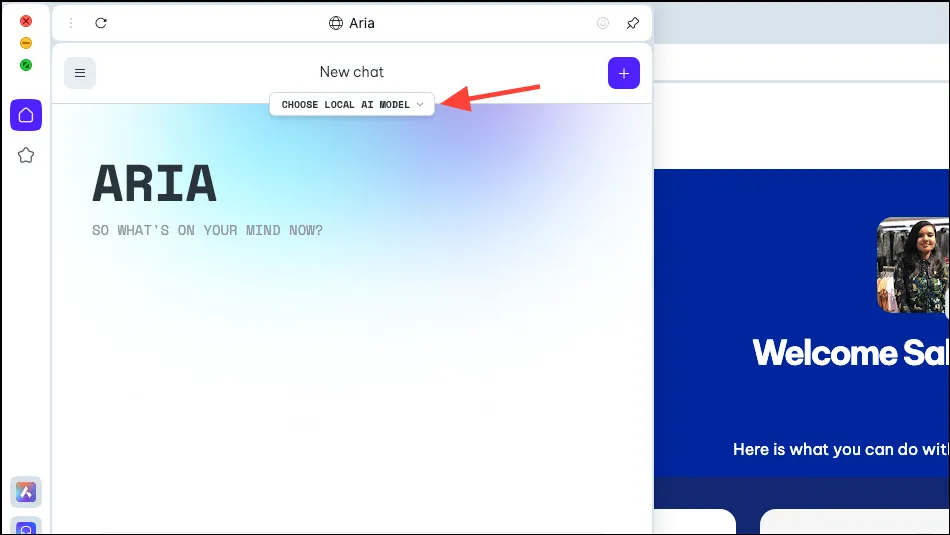

- Assim que sua conta for criada, você poderá conversar com Aria.

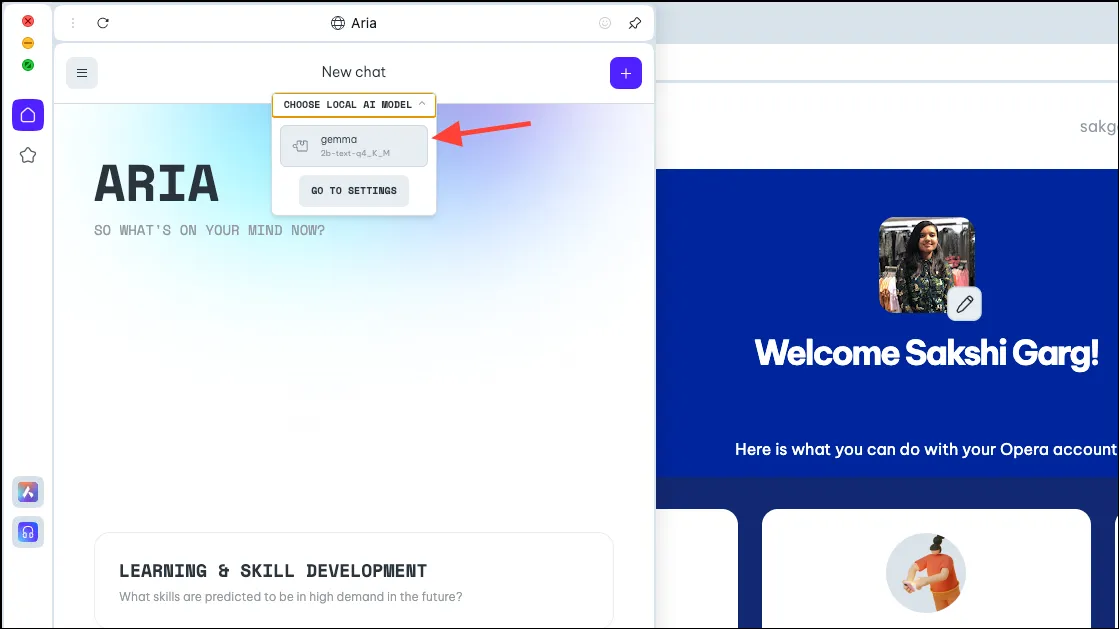

- Agora, no painel Aria, você verá uma opção, ‘Escolher modelo de IA local’. Clique nisso.

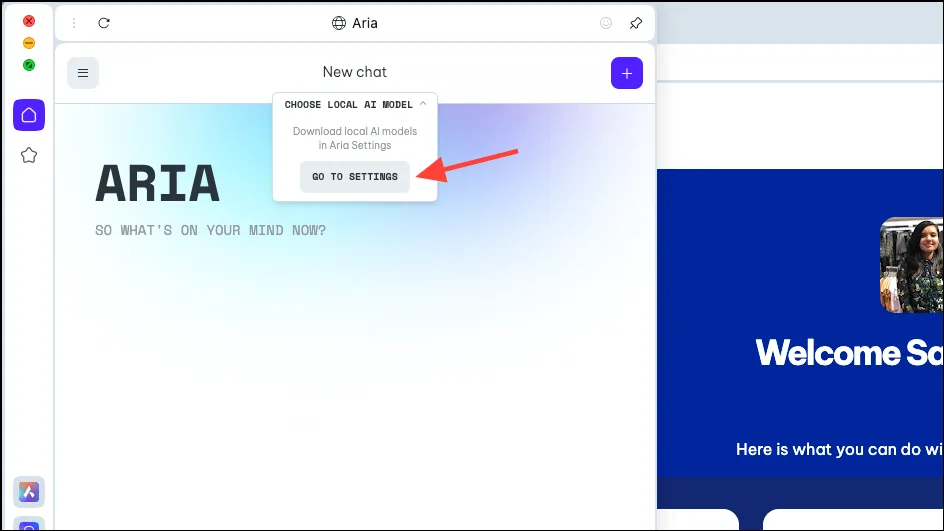

- Selecione ‘Ir para Configurações’ no menu suspenso.

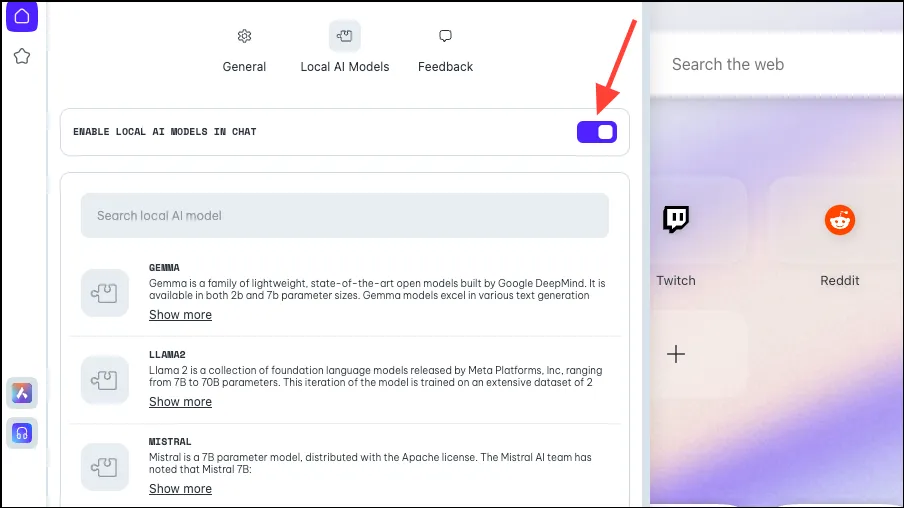

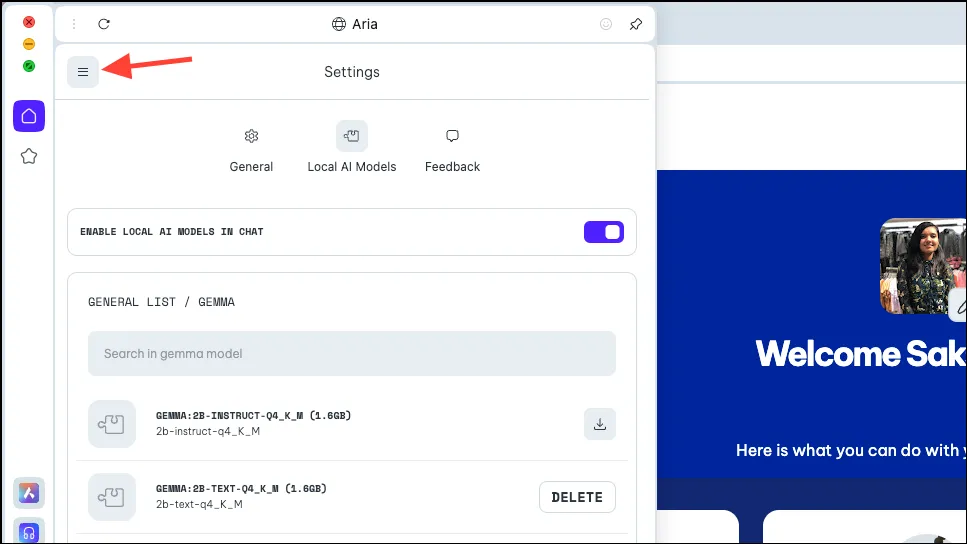

- Certifique-se de que a opção ‘Ativar IA local em bate-papos’ esteja ativada.

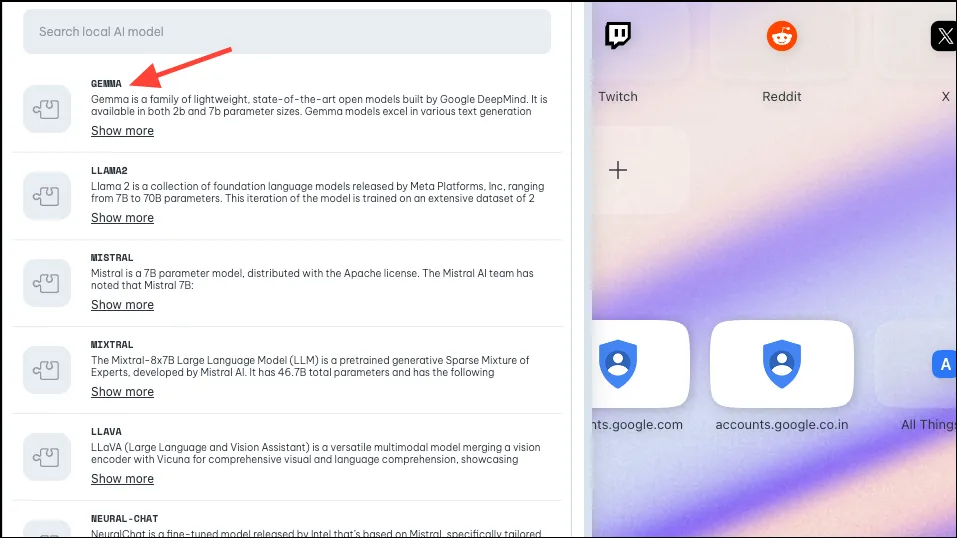

- Em seguida, escolha o modelo que deseja baixar para uso local, clicando ou pesquisando. Conforme mencionado acima, o Opera implementou suporte para aproximadamente 50 famílias de modelos com diferentes variantes, elevando o total para 150.

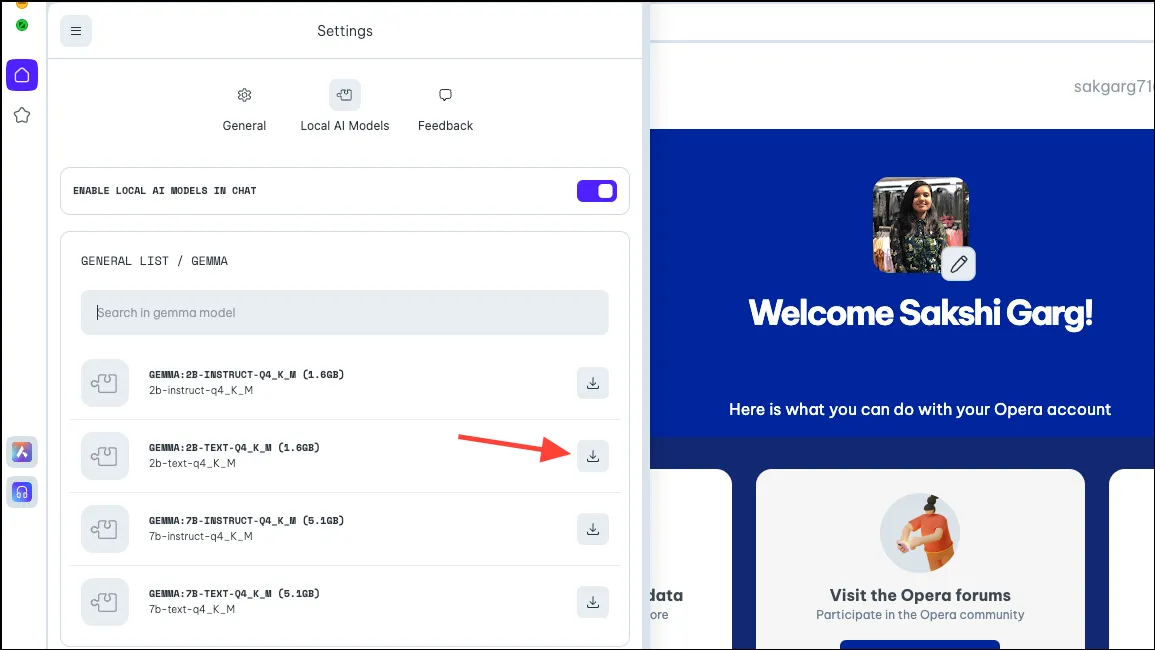

- Portanto, para alguns modelos, ao clicar em alguns modelos, como o Gemma do Google, você obterá 4 variantes diferentes. Baixe o modelo que deseja usar. Para este guia, estamos baixando o modelo de texto 2B de Gemma. Clique no botão ‘Baixar’ à direita. Você pode ver o espaço requerido pelo modelo no seu PC antes de baixá-lo.

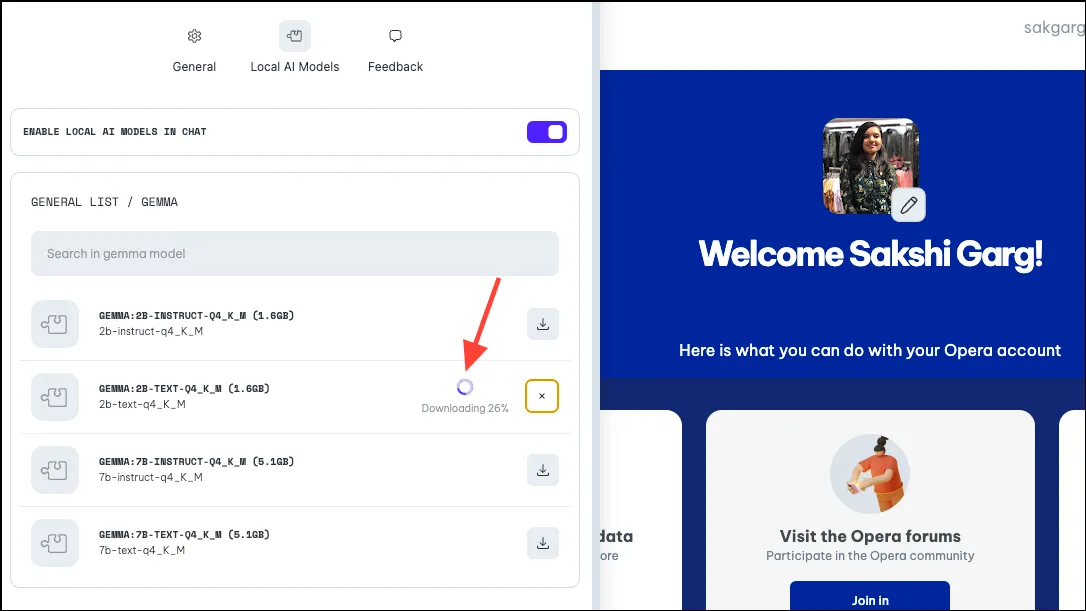

- O download demoraria algum tempo, dependendo do tamanho do modelo e da sua conexão com a internet. Você pode ver o andamento do download próximo a ele.

Usando o modelo de IA local

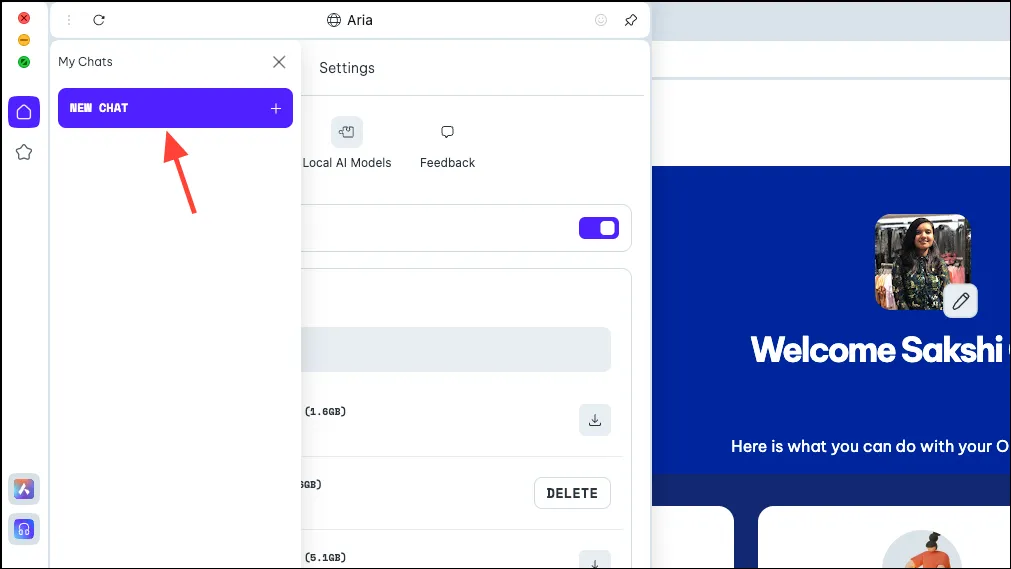

- Após o download do modelo, clique no ícone ‘Menu’ no canto superior esquerdo do painel.

- Selecione ‘Novo bate-papo’ no menu que aparece.

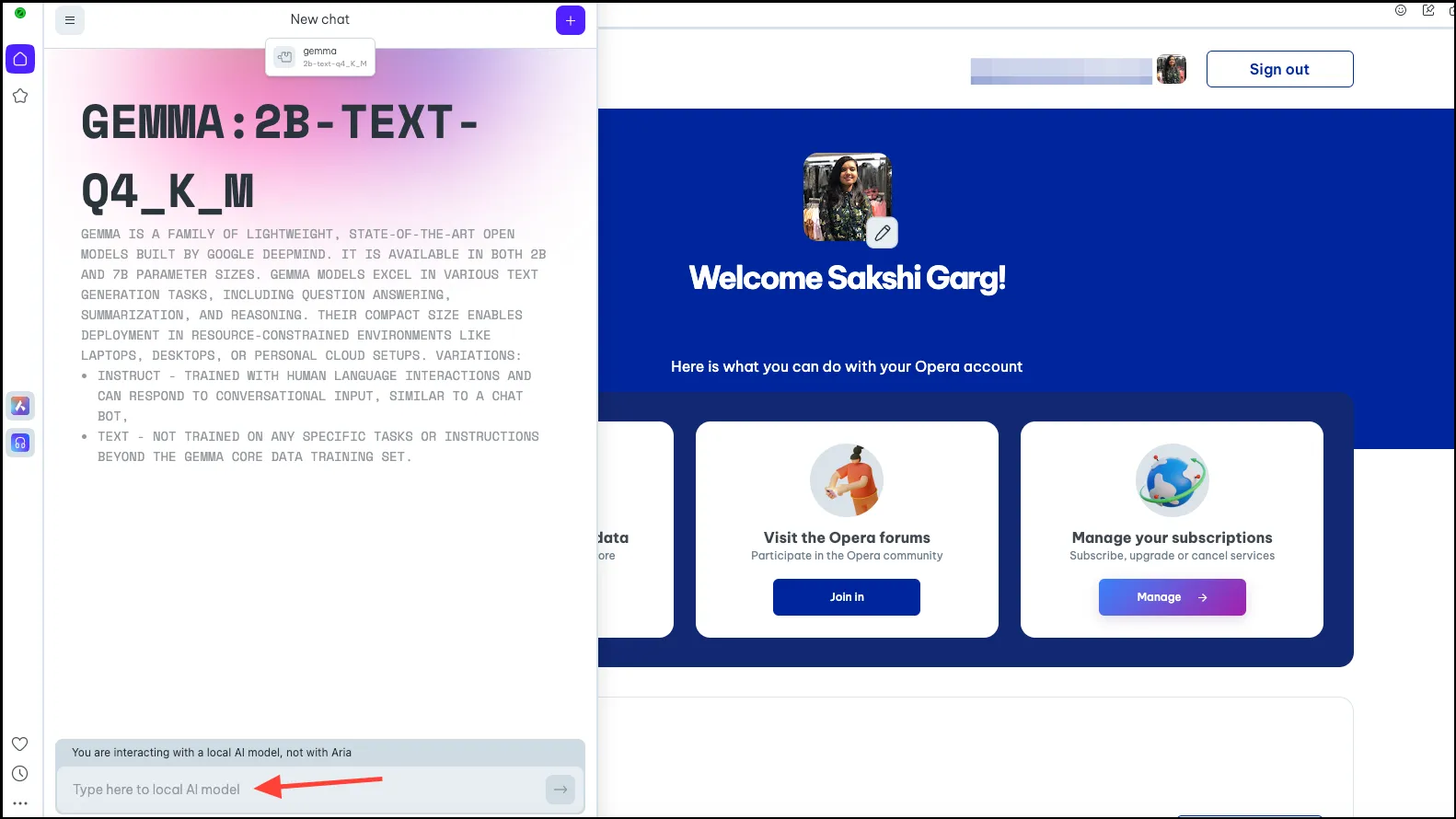

- Novamente, clique na opção ‘Escolher modelo de IA local’ na parte superior e selecione o modelo que você acabou de baixar, Gemma em nosso caso, no menu suspenso.

- Agora você mudará para o modelo de IA local de sua escolha. Digite seu prompt na barra de prompt e envie-o para a IA para iniciar suas interações locais.

- Seus bate-papos com o modelo Local AI estarão disponíveis no histórico de bate-papo, assim como seus bate-papos com Aria. Você também pode renomear os chats para melhor organização.

- Da mesma forma, você pode baixar e usar vários modelos locais de IA, mas lembre-se de que cada um requer algo entre 2 e 10 GB de espaço em seu computador.

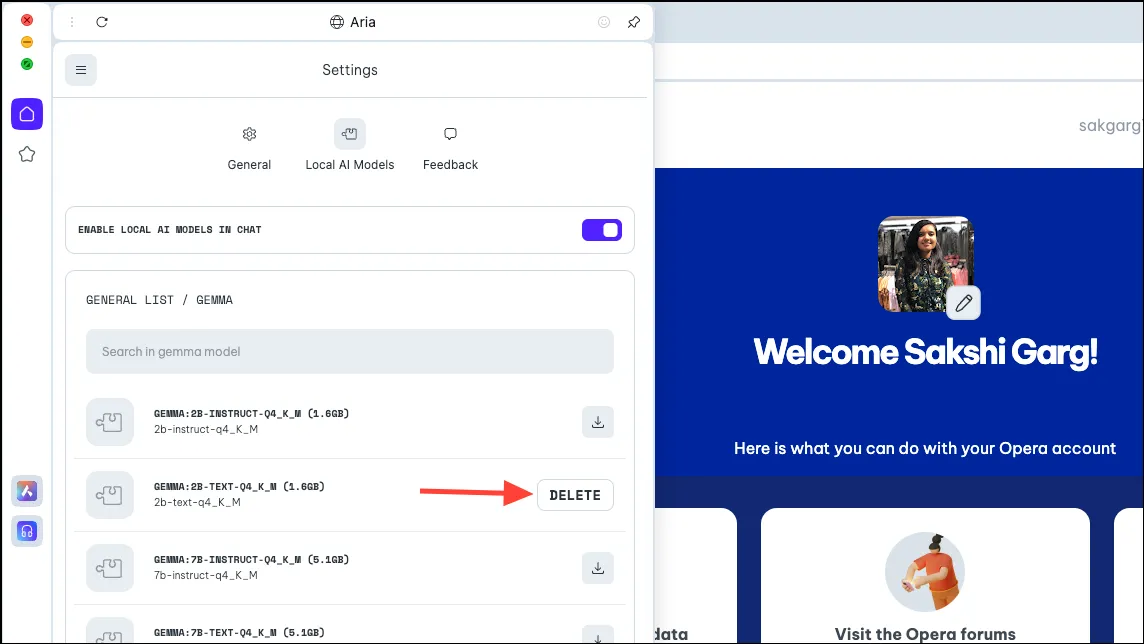

- Para excluir o modelo do seu PC, navegue até as mesmas configurações de onde baixamos o modelo anteriormente, ou seja,

Aria>Settings>Local AI Models>[Downloaded Model]. Em seguida, clique no botão ‘Excluir’.

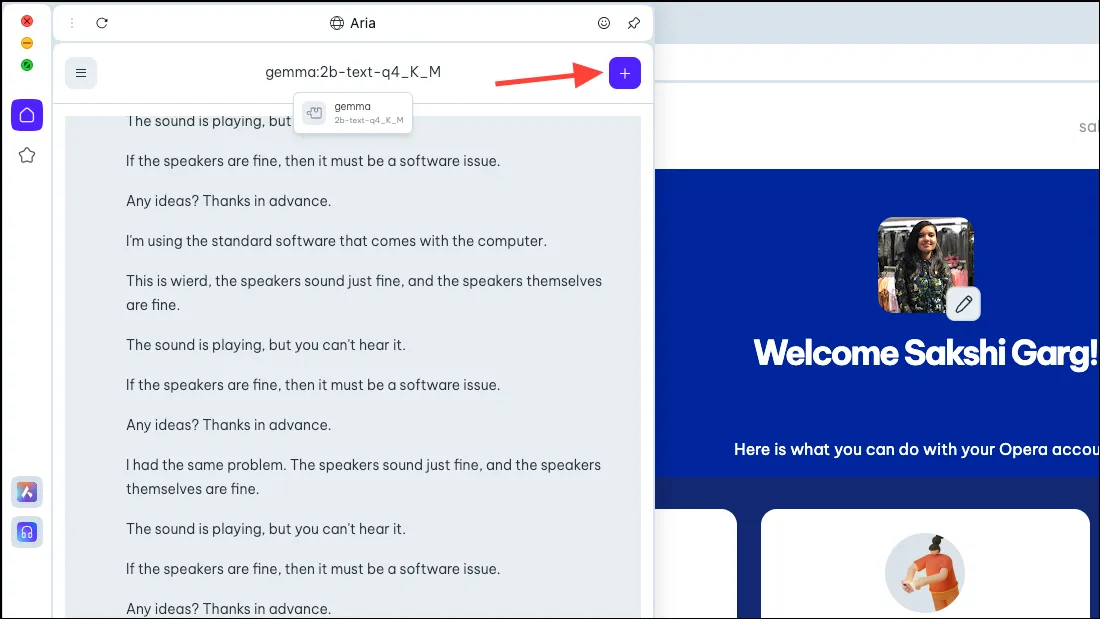

Voltar para Ária

- Para voltar ao Aria, basta iniciar um novo bate-papo com a IA. Clique no ícone ‘+’ no canto superior direito.

- O novo chat começará com a própria Aria.

É muito emocionante poder usar modelos de IA local no navegador Opera One, e não apenas do ponto de vista de segurança e privacidade. Embora nos estágios iniciais tudo seja muito simples, os possíveis casos futuros são bastante emocionantes. Um navegador com IA local pode significar que ele poderia usar sua entrada histórica com todos os seus dados; quão emocionante seria isso! E a equipe do Opera está explorando essa possibilidade.

Mas mesmo sem possibilidades futuras, as IAs locais são uma grande jogada para usuários que se preocupam com o fato de seus dados e bate-papos com a IA serem armazenados em seus servidores. Existem alguns LLMs excelentes que você pode explorar, como Llama para codificação, Phi-2 para excelentes capacidades de raciocínio e Mixtral para tarefas como geração de texto, resposta a perguntas, etc.

Deixe um comentário