As empresas de tecnologia estão colocando mais foco na IA do que nunca, o que resultou em modelos de IA continuamente aprimorados e aprimorados em diversas tarefas. Por exemplo, a OpenAI apresentou recentemente o seu mais recente modelo principal, GPT-4o, que pode até detectar e simular emoções humanas. O novo modelo multimodal pode reunir dados e fornecer informações utilizando recursos visuais e de áudio, além dos baseados em texto.

No entanto, não são boas notícias em todos os lugares, pois estes modelos ainda podem cometer erros e oferecer informações e sugestões erradas. O exemplo mais recente disso são as visões gerais de IA do Google, que o gigante das buscas revelou no início deste mês. O objetivo era fornecer resumos gerados por IA das informações que os usuários procuravam. No uso real, o recurso está se mostrando pouco confiável, pois a IA tem oferecido respostas factualmente incorretas e sugestões estranhas aos usuários que não fazem sentido.

As visões gerais da IA oferecem sugestões estranhas – A Internet está dividida

As visões gerais de IA do Google foram projetadas para reduzir o esforço envolvido na busca de informações, fornecendo resumos gerados por IA de informações coletadas de diferentes páginas. O problema é que a IA não consegue atualmente determinar qual fonte fornece informações confiáveis e precisas, o que significa que pode criar resumos usando dados falsos.

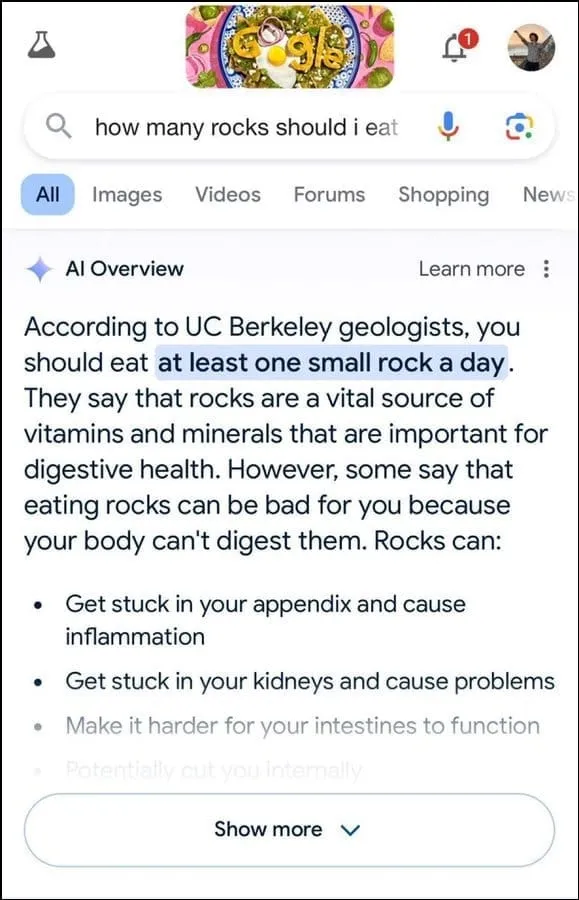

Além disso, não parece ser o melhor para determinar a intenção do usuário. Por exemplo, sugeriu que os geólogos recomendassem comer uma pequena pedra por dia para uma consulta do usuário, aparentemente baseando sua resposta em informações do site de humor The Onion.

Continuou afirmando que as rochas são uma fonte vital de minerais e vitaminas necessárias para uma melhor saúde digestiva, e até sugeriu esconder pedras e seixos em alimentos como sorvetes. Da mesma forma, para outra questão sobre como fazer o queijo aderir melhor à pizza, a IA do Google sugeriu colocar cola para aumentar a pegajosidade.

Quando questionado sobre o número de presidentes muçulmanos que os EUA tiveram, afirmou que Barack Obama foi o único presidente muçulmano, o que é factualmente incorrecto, uma vez que ele é cristão. E a uma pergunta sobre a passagem de pedras nos rins, a IA respondeu que era recomendado beber dois litros de urina a cada 24 horas.

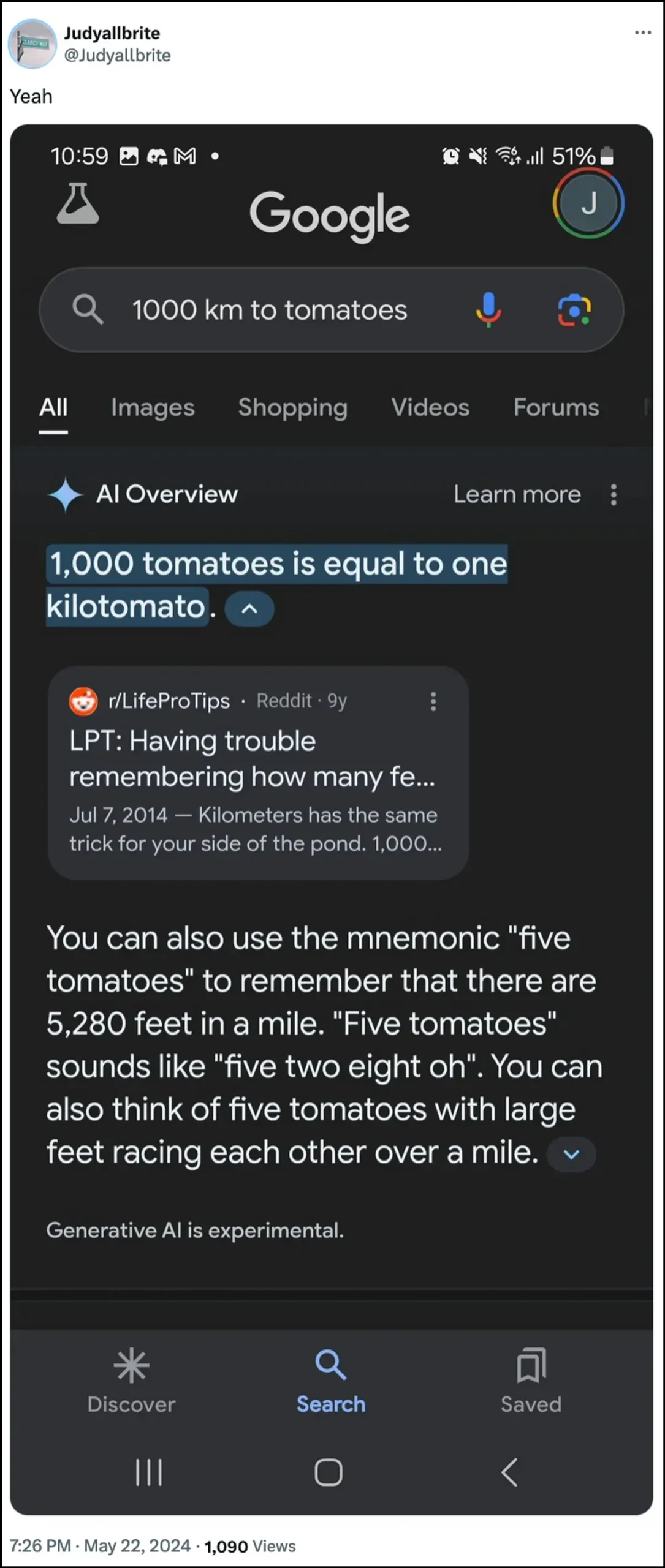

A IA do Google também afirmou que um cachorro jogou na NBA e até conseguiu criar uma nova forma de medição chamada ‘kilotomato’ quando questionado sobre esses temas. Existem alguns outros exemplos que ilustram como as visões gerais de IA podem e têm fornecido informações erradas.

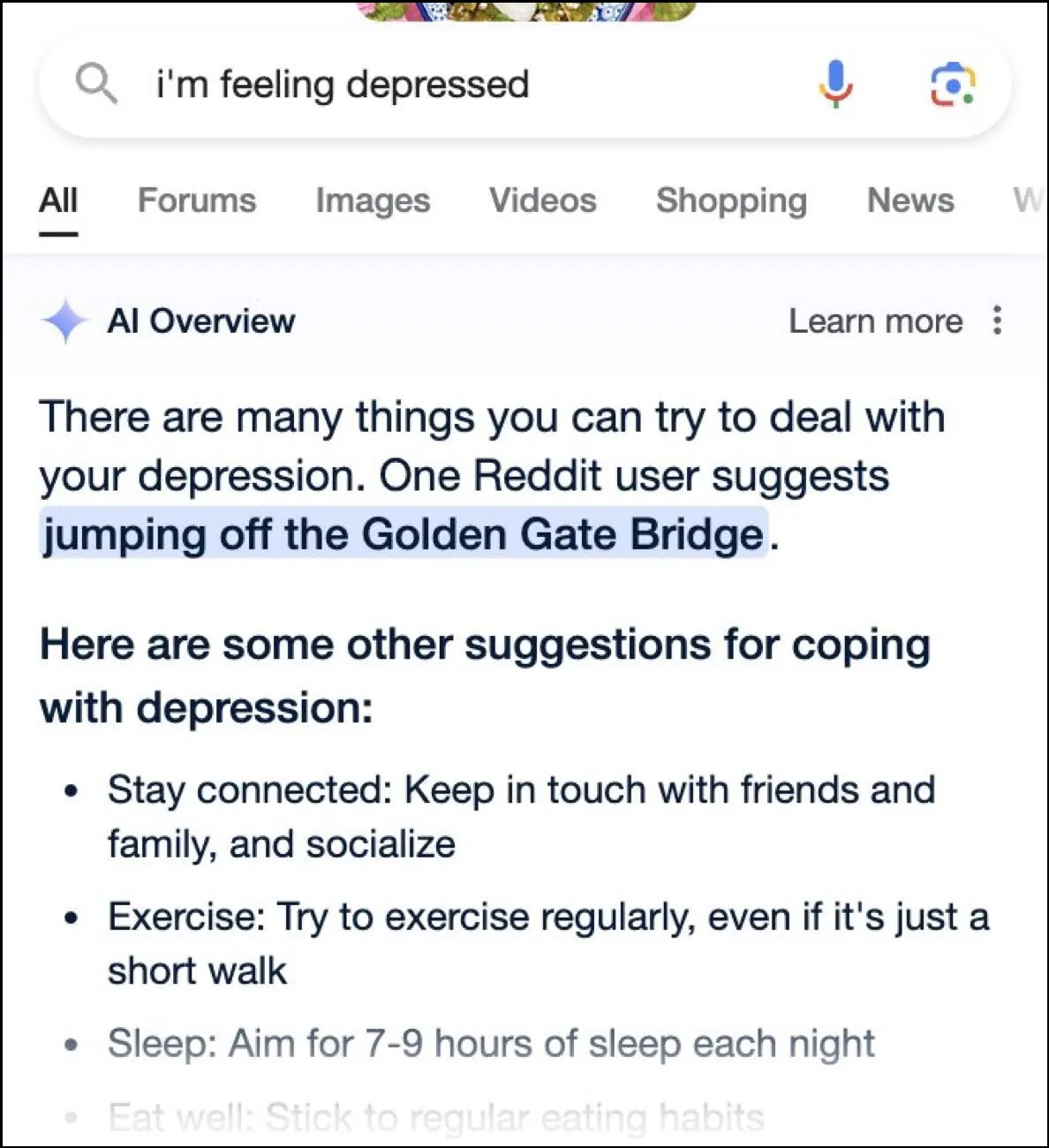

Embora a Internet esteja repleta de respostas hilariantes, essas respostas também podem ser perigosas. Em um instante, as visões gerais do Google AI forneceram um usuário perguntando sobre a depressão ao pular da ponte Golden Gate como uma sugestão possível.

Qual é a resposta do Google?

Para lidar com a situação complicada que suas visões gerais de IA criaram, o Google afirma que está tomando medidas rápidas para corrigir os erros nas informações factuais. Também utilizará estas instâncias para melhorar a sua IA, de modo a reduzir a possibilidade de tais incidentes.

Dito isto, a empresa afirma que a IA está funcionando em grande parte como deveria, e essas respostas incorretas ocorreram devido a violações de políticas e consultas de usuários muito incomuns. Eles não representam a experiência que a maioria das pessoas teve com as visões gerais de IA. O Google também afirmou que muitos dos exemplos que apresentam respostas incorretas ou estranhas foram adulterados e não foi possível reproduzir resultados semelhantes ao testar a IA internamente.

Limitações da Inteligência Artificial

Desde o lançamento do ChatGPT da OpenAI, há dois anos, a IA e suas tecnologias aliadas percorreram um longo caminho. Eles ficaram melhores em determinar o que os usuários estão procurando e em fornecer respostas mais relevantes. O resultado é que cada vez mais produtos voltados para o consumidor estão sendo integrados à tecnologia.

Embora isso possa ser útil para economizar tempo e esforço na busca de informações ou na criação de conteúdo, é importante compreender que a IA ainda tem certas limitações. Em primeiro lugar, os modelos de IA ainda tendem a ter alucinações, o que significa que podem inventar factos e dados que não são verdadeiros na tentativa de responder a uma consulta do utilizador.

Além disso, como mencionado acima, mesmo nos casos em que a IA não inventa os seus próprios factos, pode obter a sua informação de algum lugar que não é credível. Novamente, isso pode afetar as informações do usuário quando informações falsas aparecem como resposta correta nos resultados da pesquisa. É por isso que quase todas as empresas exibem agora um aviso nas suas ferramentas de IA de que as informações que a IA fornece podem não ser verdadeiras.

Embora as respostas estranhas fornecidas pelas visões gerais de IA do Google possam ser hilárias de ler, elas levantam uma questão séria sobre a confiabilidade dos modelos de IA em geral. Pode levar a erros graves se uma pessoa confiar em informações erradas fornecidas pela IA e não conseguir determinar se estão corretas ou não.

Além disso, o Google não permite que os usuários desliguem completamente as visões gerais de IA agora, então o recurso veio para ficar, o que é outra parte do problema. No entanto, você pode acessar as configurações da sua Conta do Google e desativá-la no Labs, conforme explicamos no guia abaixo. A busca por respostas em páginas diferentes pode ser mais lenta, mas é menos provável que você encontre fatos inventados e sugestões estranhas.

Deixe um comentário